엔비디아, AI 추론 칩 시장의 새로운 판을 짜다: 그록(Groq) 인수와 LPU 아키텍처의 혁신

최근 인공지능(AI) 시장의 성장은 눈부시며, 특히 AI 반도체 분야는 그 핵심 동력으로 작용하고 있습니다. 이 경쟁의 최전선에서 엔비디아(NVIDIA)가 흥미로운 움직임을 보였습니다. 구글의 TPU(Tensor Processing Unit) 공세가 거세지는 가운데, 엔비디아가 고성능 추론 AI 칩 스타트업인 그록(Groq)의 기술 라이선스 및 핵심 엔지니어를 확보했다는 소식이 전해졌습니다. 이는 단순한 기업 인수를 넘어, AI 반도체 시장, 특히 ‘추론(Inference)’ 영역의 미래를 재편할 중요한 신호탄으로 해석됩니다. 과연 그록은 어떤 회사이며, 엔비디아는 왜 이 시점에서 그록의 기술에 주목했을까요? 본 글에서는 엔비디아 그록 인수 AI 추론 칩 시장 변화 에 대해 알아보겠습니다. 그록의 혁신적인 LPU(Language Processing Unit) 아키텍처부터 엔비디아의 전략적 행보까지 심층적으로 분석해보겠습니다. IT 최신 소식을 전하는 blog.eomeo.net에서 함께 살펴보시죠.

그록(Groq)이란 무엇인가: LPU의 탄생과 초고속 추론의 비밀

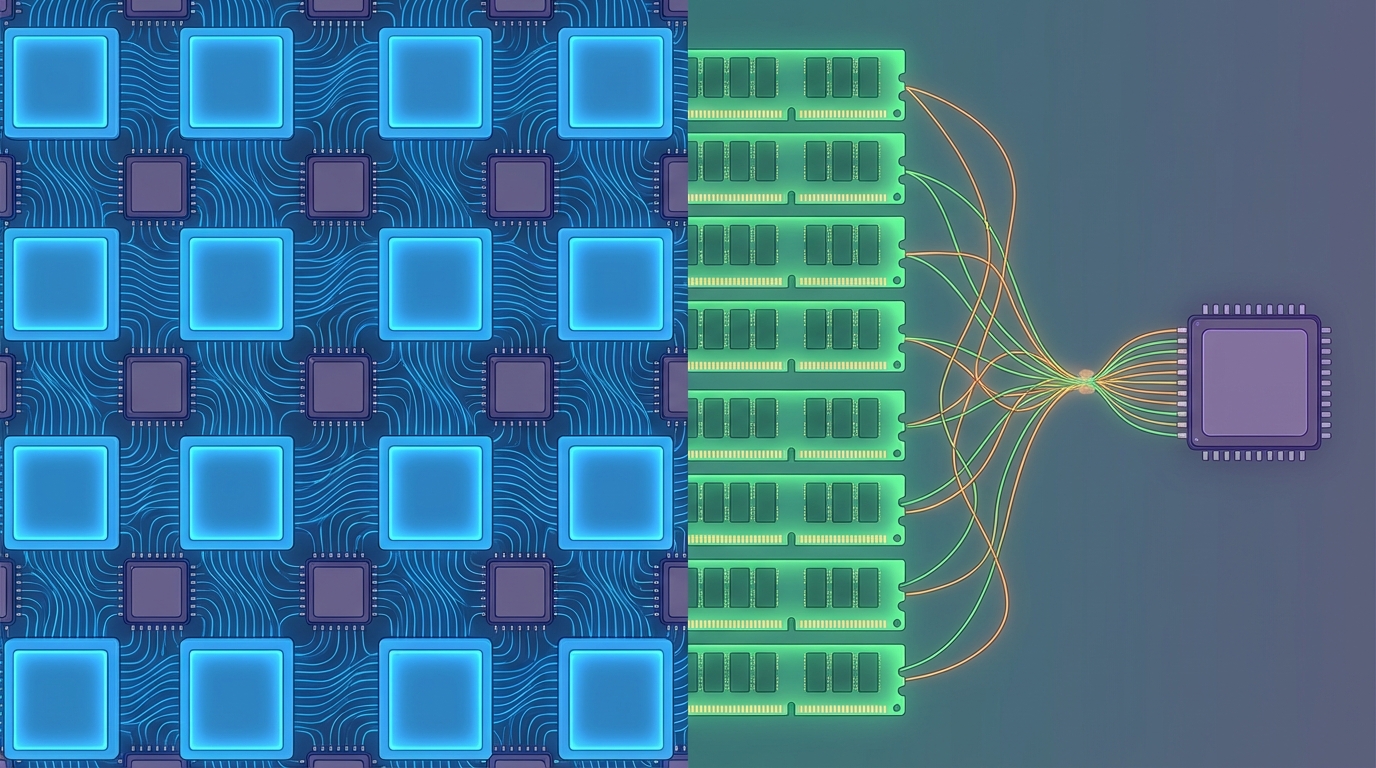

그록은 2016년 구글 TPU를 설계했던 조나산 로스(Jonathan Ross)를 포함한 엔지니어들이 설립한 스타트업입니다. 이들은 기존 AI 반도체의 한계를 극복하고자 ‘추론 전용’에 특화된 LPU(Language Processing Unit)라는 새로운 유형의 프로세싱 칩을 개발했습니다. LPU의 가장 큰 특징은 HBM(High Bandwidth Memory)이나 LPDDR(Low Power Double Data Rate)과 같은 외부 DRAM 대신 SRAM을 칩 내부에 직접 통합하여 사용한다는 점입니다. 이는 ‘HBM 없이도 빠르다’라는 그록의 독특한 강점으로 이어집니다.

기존 GPU나 TPU는 HBM을 통해 빠른 대역폭을 확보하려 했지만, 이 과정에서 프로세서와 메모리 간의 데이터 왕복에 따른 ‘레이턴시(Latency)’ 문제가 발생했습니다. 즉, 자주 사용하는 데이터는 L1, L2 캐시와 같은 온칩 SRAM에 저장되지만, 모든 데이터를 SRAM에 담을 수는 없기에 결국 HBM에서 데이터를 불러와야 하는 병목 현상이 불가피했던 것입니다. 이는 AI 모델의 실시간 응답 속도를 저해하는 주요 원인이었습니다.

반면 그록의 LPU는 사실상 ‘캐시 메모리만으로 이루어진’ 구조에 가깝습니다. 모든 필요한 데이터와 가중치(weights)를 칩 내의 대용량 SRAM에 직접 배치하여, 외부 메모리와의 통신 없이 모든 연산을 온칩에서 처리합니다. 이로 인해 데이터 왕복에 드는 시간을 극적으로 줄이고, 예측 가능한 ‘결정론적 실행(Deterministic Execution)’ 시간을 확보할 수 있습니다. 개발자는 데이터가 어느 위치에 어떤 타이밍에 접근 가능한지 정확히 알 수 있어, 최적화된 코드를 통해 거의 제로에 가까운 지연 시간으로 초당 수백 단어 수준의 압도적인 추론 속도를 구현할 수 있습니다. 실제로 그록의 클라우드 서비스에서 대규모 언어 모델(LLM)을 구동하면 초당 400~500개의 단어를 쏟아내는 놀라운 성능을 확인할 수 있습니다.

엔비디아의 전략적 선택: 그록 기술이 가져올 변화

엔비디아가 그록의 기술 라이선스와 핵심 인재를 확보하려는 움직임은 현재 AI 반도체 시장의 주요 과제와 밀접하게 연결됩니다. GPU는 범용적인 연산에 강하지만, AI 추론 시장이 급격히 성장하면서 실시간 응답 속도와 효율성이 더욱 중요해지고 있습니다. 특히 여러 개의 GPU를 MVLink나 인피니티 밴드(Infinity Band)로 연결하여 거대한 하나의 컴퓨터처럼 활용하려는 렉스케일(Rack-scale) 컴퓨팅 환경에서 ‘코히어런스 타임(Coherence Time)’, 즉 모든 GPU가 지연 없이 동기화되어 작동하는 능력은 핵심적인 과제입니다. 열 관리 문제와 함께 이 레이턴시 문제는 대규모 AI 인프라 구축의 큰 난관으로 지적되어 왔습니다.

그록의 SRAM 중심 LPU 아키텍처는 바로 이러한 레이턴시 문제를 해결할 실마리를 제공할 수 있습니다. 모든 연산을 예측 가능한 시간 안에 온칩에서 처리하는 그록의 설계 철학은 엔비디아가 차세대 추론 아키텍처, 특히 MVL 72, MVL 144와 같은 렉스케일 GPU 시스템의 동기화 및 성능 일관성 문제를 개선하는 데 영감을 줄 수 있습니다. 엔비디아는 이미 호퍼(Hopper)나 블랙웰(Blackwell) 같은 GPU 아키텍처 내부에 SRAM 구도를 활용하여 특정 연산을 오프로딩하는 방식을 도입하고 있습니다. 그록의 핵심 인력은 구글 TPU 설계 경험을 바탕으로 SRAM을 극대화한 오프로딩 기술에 대한 깊은 이해를 가지고 있으며, 이는 엔비디아가 쿠다(CUDA) 기반 라이브러리를 통해 GPU를 더욱 최적화하는 데 기여할 것입니다.

결과적으로 엔비디아는 그록의 기술을 통해 GPU의 약점으로 지적되던 추론 레이턴시(추론시 지연발생)의 ‘베리언스(Variance)’를 줄이고(NPU보다 더 빠른 성능), 대규모 AI 모델의 실시간 응답성을 더욱 향상시킬 수 있을 것입니다. 이는 구글의 강력한 TPU 공세에 맞서 엔비디아가 추론 시장에서의 주도권을 더욱 공고히 하려는 전략적 포석으로 풀이됩니다. 단순히 HBM 경쟁을 피하는 것을 넘어, 특정 애플리케이션에 최적화된 초고속 추론 솔루션을 제공하며 시장의 다양한 요구에 대응하겠다는 의지로 볼 수 있습니다. AI 기술 동향에 대한 더 많은 정보는 어머넷 블로그에서 확인하실 수 있습니다.

추론 AI 칩 시장의 미래와 엔비디아의 포지셔닝

AI 모델의 학습(Training)과 추론(Inference)은 AI 반도체 시장의 양대 축입니다. 초기에는 학습용 칩에 집중되었던 관심이 이제는 일상생활과 산업 전반에 AI가 확산되면서 추론 칩의 중요성으로 옮겨가고 있습니다. 스마트폰, 엣지 디바이스, 클라우드 서비스 등 다양한 환경에서 실시간으로 AI 모델을 구동해야 하는 수요가 폭증하면서, 저전력 고효율 추론 칩에 대한 기술 경쟁이 심화되고 있습니다.

그록의 LPU는 이러한 추론 시장의 요구를 정확히 겨냥한 칩입니다. 비록 칩 크기가 커지고 생산 비용이 높다는 단점이 있지만, 극도로 낮은 레이턴시와 일관된 성능이 요구되는 특정 실시간 AI 애플리케이션(예: 실시간 음성 비서, 자율주행, 금융 거래 예측)에서는 독보적인 강점을 가질 수 있습니다. 엔비디아는 이러한 그록의 ‘결정론적 실행’ 철학을 자사의 차세대 아키텍처에 통합함으로써, 범용 GPU의 유연성과 그록 LPU의 실시간 성능을 결합한 하이브리드 솔루션을 제공할 가능성이 있습니다.

이는 엔비디아가 단순히 학습 시장의 지배력을 유지하는 것을 넘어, 이제는 폭발적으로 성장하는 추론 시장에서도 독보적인 위치를 차지하겠다는 강력한 의지를 보여줍니다. 기존의 호퍼(Hopper)나 블랙웰(Blackwell) 아키텍처에서 GDDR을 도입하여 렉 단위 컴퓨팅 효율성을 높이고, 프리필(Prefill) 단계와 디코드(Decode) 단계를 세분화하여 처리하는 CPX(Custom Processing Unit for Inference)와 같은 접근 방식은 이미 엔비디아가 추론 최적화에 힘쓰고 있음을 방증합니다. 그록의 기술 흡수는 이러한 노력에 더욱 박차를 가하여, 엔비디아가 다양한 추론 워크로드에 최적화된 솔루션을 제공하는 데 결정적인 역할을 할 것입니다.

결론: AI 반도체 지형의 변화를 주도하는 엔비디아

오늘은 엔비디아 그록 인수 AI 추론 칩 시장 변화 에 대해 알아 보았습니다. 엔비디아의 그록 기술 라이선스 및 인력 확보는 AI 반도체 시장의 진화를 상징하는 중요한 사건입니다. HBM의 대역폭 한계를 넘어 실시간, 저지연 추론의 필요성이 커지면서, 그록의 SRAM 중심 LPU 아키텍처는 새로운 가능성을 제시했습니다. 엔비디아는 이를 통해 구글 TPU의 공세에 효과적으로 대응하고, 렉스케일 AI 시스템의 성능 일관성 문제를 해결하며, 궁극적으로 다양한 AI 애플리케이션에 최적화된 추론 솔루션을 제공할 것입니다. 이로써 엔비디아는 AI 학습 시장뿐만 아니라, 급변하는 추론 시장에서도 선두를 유지하며 AI 반도체 산업의 미래를 계속해서 주도해 나갈 것으로 예상됩니다. 앞으로 엔비디아와 그록의 시너지가 어떤 혁신적인 결과물을 가져올지 귀추가 주목됩니다. 최신 IT 뉴스와 분석은 어머넷 블로그에서 계속 업데이트됩니다.